Tài liệu liên quan

Danh mục liên quan

Thời gian đọc của bạn

Bài viết liên quan

Kiến thức SEO Tìm Hiểu Nhóm Từ Khóa và Lợi Ích Trong SEO

Kiến thức SEO Hướng Dẫn Xóa Schema Sai và Dư Thừa để Bảo Vệ SEO

Tối ưu robots.txt là gì cho WordPress giúp điều hướng robot tìm kiếm hiệu quả, bảo mật website và nâng cao thứ hạng SEO một cách chuẩn xác và chuyên nghiệp.

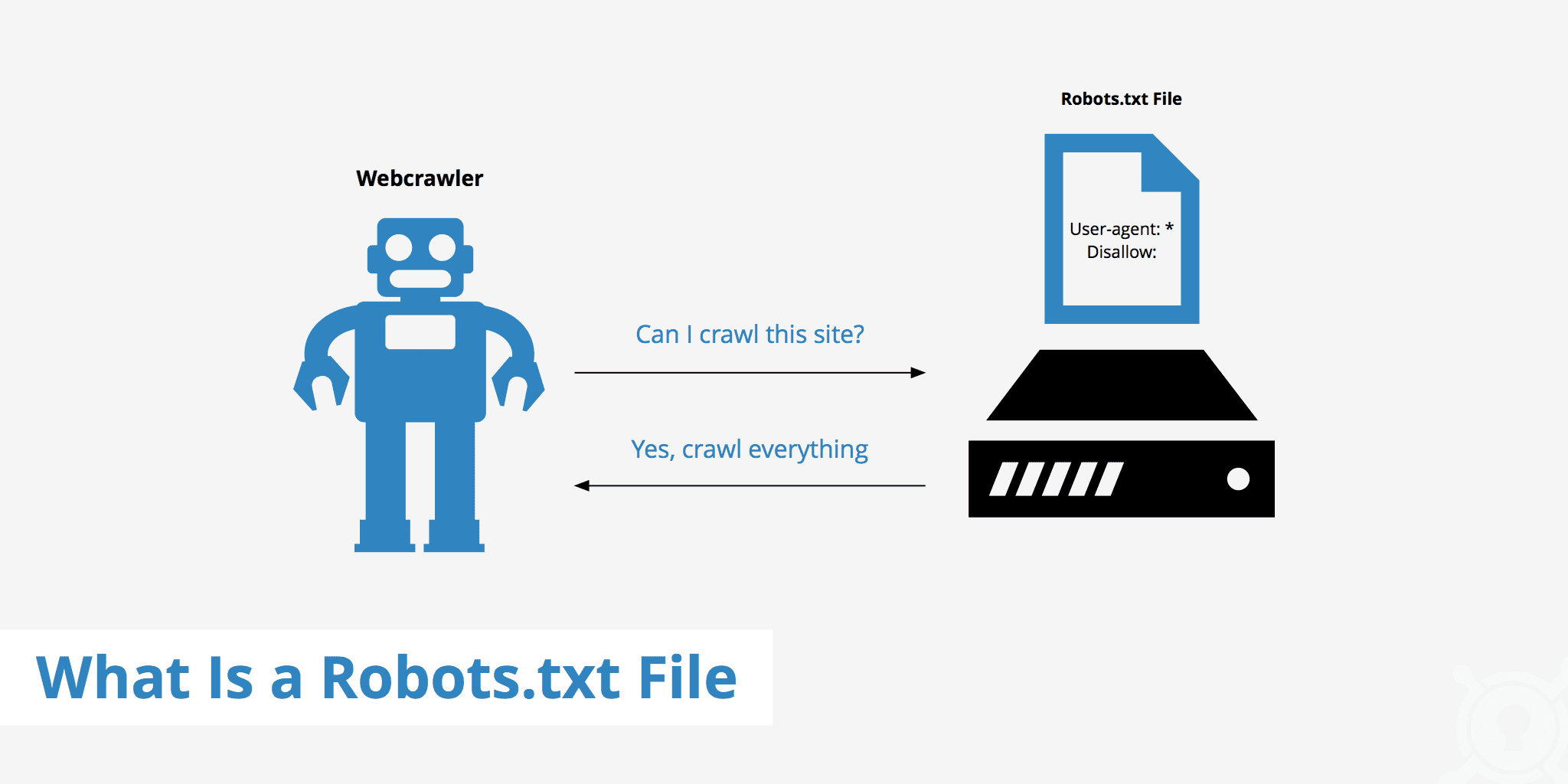

Bạn có biết file robots.txt chính là “cánh cổng” quyết định cách các công cụ tìm kiếm tương tác với website WordPress của bạn không? Nó hoạt động như một người chỉ đường, cho phép hoặc ngăn chặn các bot tìm kiếm (còn gọi là spiders hay crawlers) truy cập vào những khu vực nhất định trên trang web. Đây là một tệp văn bản đơn giản nhưng lại nắm giữ sức mạnh to lớn trong việc định hình chiến lược SEO tổng thể của bạn. Một cấu hình chuẩn xác có thể giúp website được index nhanh hơn, bảo vệ các thông tin nhạy cảm và cải thiện hiệu quả SEO tổng thể.

Tuy nhiên, rất nhiều webmaster, đặc biệt là những người mới bắt đầu, thường bỏ qua hoặc cấu hình sai file robots.txt. Việc này có thể dẫn đến những hậu quả không mong muốn như các trang quan trọng bị mất index, tài nguyên bị lãng phí do bot crawl các trang không cần thiết, hoặc tệ hơn là gây ra các rủi ro về bảo mật. Một lỗi nhỏ trong cú pháp cũng có thể vô tình chặn toàn bộ website khỏi các công cụ tìm kiếm. Vì vậy, hiểu rõ và tối ưu file này là một bước đi không thể thiếu.

Bài viết này sẽ là kim chỉ nam toàn diện, hướng dẫn bạn từ những khái niệm cơ bản nhất đến các kỹ thuật cấu hình nâng cao. Chúng ta sẽ cùng nhau tìm hiểu cách tạo file robots.txt chuẩn cho WordPress, cách điều hướng robot tìm kiếm hiệu quả, các quy tắc bảo mật quan trọng và những lưu ý cần thiết để duy trì một file robots.txt tối ưu, góp phần nâng cao thứ hạng website của bạn một cách bền vững.

Để bắt đầu tối ưu, trước hết chúng ta cần hiểu rõ về cấu trúc và cách tạo ra file robots.txt. Đây là nền tảng cơ bản để bạn có thể tự tin quản lý và điều chỉnh các quy tắc cho phù hợp với website của mình.

File robots.txt là một tệp văn bản đơn giản, không có định dạng phức tạp. Nó sử dụng một vài cú pháp chính để giao tiếp với các bot tìm kiếm. Bạn chỉ cần nắm vững những chỉ thị cơ bản này là đã có thể làm chủ được nó. Để hiểu chi tiết hơn về cách tối ưu các yếu tố kỹ thuật trong website, bạn có thể tham khảo bài viết Seo Onpage là gì.

Cấu trúc của file bao gồm các quy tắc, mỗi quy tắc thường có hai phần chính:

User-agent: Googlebot áp dụng riêng cho bot của Google, trong khi User-agent: * áp dụng cho tất cả các bot. Dấu sao (*) là một ký tự đại diện (wildcard).Disallow: /wp-admin/ sẽ ngăn bot vào khu vực quản trị của WordPress./wp-content/plugins/ nhưng lại muốn cho phép bot truy cập một file CSS cụ thể bên trong đó.Về vị trí, file robots.txt bắt buộc phải được đặt trong thư mục gốc (root directory) của website. Ví dụ, nếu tên miền của bạn là buimanhduc.com, thì file robots.txt phải truy cập được qua đường dẫn buimanhduc.com/robots.txt.

Có hai cách phổ biến để tạo file robots.txt cho website WordPress: tạo thủ công hoặc sử dụng plugin hỗ trợ. Mỗi cách đều có ưu và nhược điểm riêng.

1. Tạo file thủ công:

Đây là cách làm trực tiếp và giúp bạn kiểm soát hoàn toàn nội dung file. Các bước thực hiện rất đơn giản:

robots.txt.public_html hoặc www).2. Sử dụng plugin SEO:

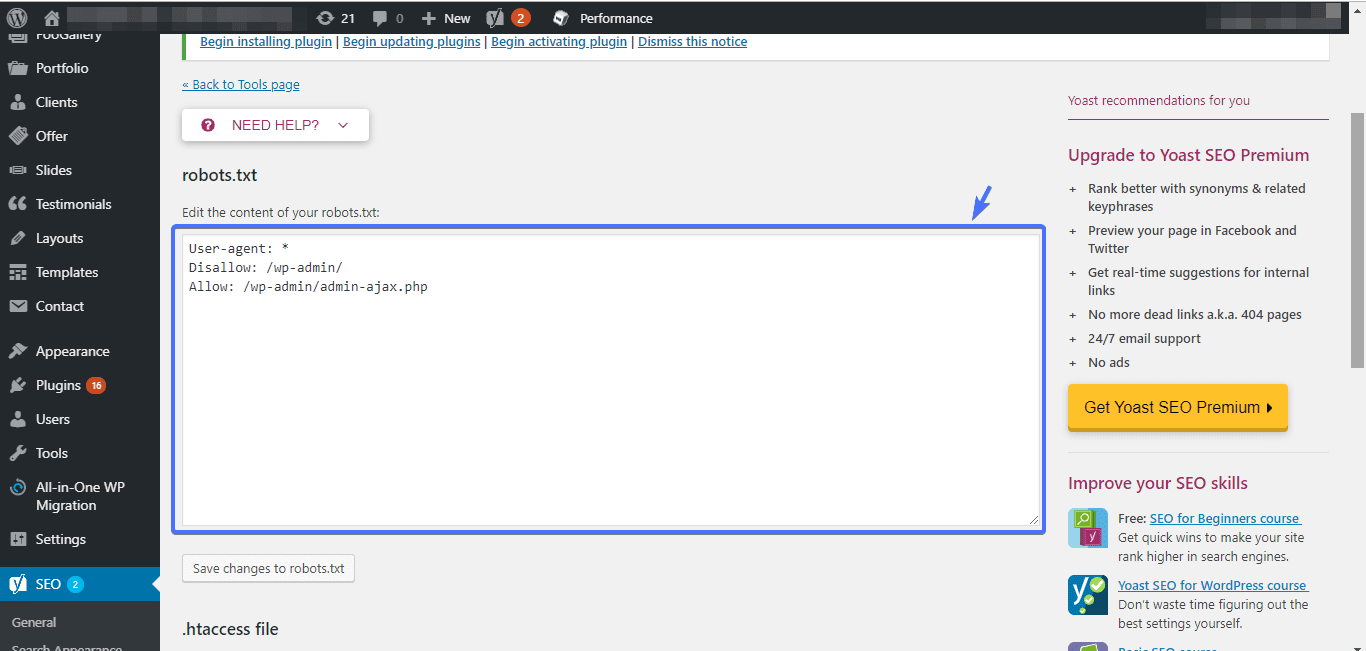

Hầu hết các plugin SEO phổ biến như Yoast SEO, Rank Math, hoặc All in One SEO Pack đều cung cấp công cụ để tạo và chỉnh sửa file robots.txt ngay từ trang quản trị WordPress. Đây là cách làm an toàn và tiện lợi hơn cho người mới bắt đầu.

Rank Math SEO > General Settings > Edit robots.txt.Yoast SEO > Tools > File editor.Bạn chỉ cần nhập nội dung vào khung soạn thảo và lưu lại. Plugin sẽ tự động tạo hoặc cập nhật file robots.txt trong thư mục gốc cho bạn.

Ví dụ mẫu file robots.txt chuẩn cho website WordPress:

Dưới đây là một cấu hình cơ bản và an toàn mà bạn có thể sử dụng cho hầu hết các website WordPress:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-content/plugins/ Disallow: /wp-content/themes/ Disallow: /readme.html Allow: /wp-admin/admin-ajax.php Sitemap: https://yourdomain.com/sitemap_index.xml

File mẫu này chặn các thư mục cốt lõi và các tệp không cần thiết, đồng thời chỉ định đường dẫn đến sitemap, giúp bot tìm kiếm hoạt động hiệu quả hơn.

Sau khi đã tạo được file robots.txt, bước tiếp theo là cấu hình các quy tắc một cách thông minh để tối ưu hóa việc thu thập dữ liệu của công cụ tìm kiếm. Một cấu hình tốt sẽ giúp Googlebot tập trung vào những nội dung giá trị nhất, từ đó đẩy nhanh quá trình index và cải thiện thứ hạng SEO. Hiểu thêm về các chỉ số trải nghiệm website có thể tham khảo Core Web Vitals.

Mục tiêu của chúng ta là “dẫn đường” cho bot, cho phép chúng vào những nơi cần vào và chặn những nơi không cần thiết. Điều này giúp tiết kiệm ngân sách thu thập dữ liệu (crawl budget) và tránh các vấn đề về trùng lặp nội dung.

Những gì nên cho phép (Allow):

Disallow, mọi thứ đều được cho phép./wp-content/uploads/ chứa tất cả hình ảnh và tệp media của bạn. Chặn thư mục này sẽ khiến hình ảnh không thể xuất hiện trên Google Images, làm mất đi một nguồn traffic tiềm năng.Những gì nên chặn (Disallow):

/?s=keyword không mang lại giá trị cho người dùng từ công cụ tìm kiếm và có thể tạo ra vô số trang có nội dung mỏng (thin content). Bạn nên chặn chúng bằng quy tắc: Disallow: /?s=./wp-admin/, /wp-includes/ cần được chặn để bảo mật và tránh lãng phí tài nguyên crawl.Một lỗi phổ biến là quá “nhiệt tình” trong việc chặn, dẫn đến việc vô tình ngăn Googlebot truy cập các tài nguyên quan trọng. Điều này tạo ra lỗi crawl và ảnh hưởng trực tiếp đến khả năng xếp hạng của website.

Để tránh điều này, hãy tuân thủ nguyên tắc: chỉ chặn những gì bạn chắc chắn không muốn được index. Một cấu hình thông minh sẽ ưu tiên crawl các thư mục chính và hạn chế các tài nguyên nặng hoặc không cần thiết.

Ví dụ, thay vì chặn toàn bộ thư mục /wp-content/plugins/, bạn có thể muốn cho phép truy cập một số file CSS hoặc JS trong đó để trang web hiển thị đúng. Cú pháp Allow sẽ phát huy tác dụng ở đây. Tuy nhiên, việc này khá phức tạp và thường không cần thiết nếu theme và plugin của bạn được code chuẩn.

Một trong những cách hiệu quả nhất để tăng tốc SEO thông qua robots.txt là tích hợp sitemap. Bằng cách thêm dòng lệnh Sitemap: https://yourdomain.com/sitemap.xml vào cuối file, bạn đã cung cấp cho công cụ tìm kiếm một bản đồ chi tiết về tất cả các URL quan trọng. Điều này giúp bot khám phá nội dung mới nhanh hơn và đảm bảo không bỏ sót bất kỳ trang nào, đặc biệt là với các website lớn có cấu trúc phức tạp.

Bên cạnh vai trò định hướng SEO, file robots.txt còn là một lớp phòng vệ đầu tiên giúp bảo vệ các khu vực nhạy cảm của website khỏi sự tò mò của các bot. Mặc dù nó không phải là một biện pháp bảo mật tuyệt đối, việc chặn truy cập đúng cách sẽ giảm thiểu đáng kể nguy cơ bị tấn công tự động.

Trong cấu trúc của WordPress, có những tệp và thư mục chứa mã nguồn cốt lõi, thông tin cấu hình và các dữ liệu không dành cho công chúng. Việc để các bot, đặc biệt là các bot xấu, truy cập vào những khu vực này có thể làm lộ các lỗ hổng bảo mật tiềm ẩn.

Dưới đây là danh sách các tệp và thư mục bạn nên ưu tiên chặn:

Lý do chính của việc chặn là để hạn chế “bề mặt tấn công”. Khi kẻ xấu không thể tự động quét và tìm ra phiên bản WordPress, danh sách plugin, hay cấu trúc thư mục của bạn, chúng sẽ gặp nhiều khó khăn hơn trong việc tìm kiếm và khai thác lỗ hổng.

Việc chặn các thư mục trên phải được thực hiện cẩn thận để không vô tình chặn các tài nguyên cần thiết cho việc hiển thị trang, như CSS và JavaScript. Một cấu hình sai lầm có thể khiến Google không đọc được trang web của bạn một cách hoàn chỉnh. Để hiểu thêm về các công cụ và kỹ thuật kiểm tra SEO Onpage, bạn có thể xem bài Seo Onpage là gì.

Dưới đây là các dòng lệnh chi tiết bạn nên thêm vào file robots.txt để bảo vệ website một cách hiệu quả:

User-agent: * # Chặn các thư mục cốt lõi của WordPress Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-login.php Disallow: /wp-register.php # Chặn các thư mục nội dung không cần thiết Disallow: /wp-content/plugins/ Disallow: /wp-content/themes/ Disallow: /wp-content/cache/ # Chặn các tệp tin không cần thiết khác Disallow: /readme.html Disallow: /license.txt Disallow: /xmlrpc.php Disallow: /trackback/ # Cho phép các file cần thiết cho AJAX Allow: /wp-admin/admin-ajax.php

Lưu ý dòng Allow: /wp-admin/admin-ajax.php. Tệp admin-ajax.php thường được các theme và plugin sử dụng để thực hiện các chức năng động (dynamic functions) trên giao diện người dùng (ví dụ: tải thêm bài viết, gửi biểu mẫu). Việc cho phép bot truy cập vào tệp này đảm bảo các chức năng đó không bị ảnh hưởng, giúp Google có thể hiểu và tương tác với trang của bạn một cách đầy đủ nhất.

Tối ưu file robots.txt không chỉ là việc thêm vào các quy tắc chặn và cho phép. Nó đòi hỏi sự cẩn trọng và theo dõi thường xuyên để đảm bảo mọi thứ hoạt động như ý muốn và không gây ra tác dụng phụ. Một sai lầm nhỏ cũng có thể phá hỏng nỗ lực SEO của bạn.

Đây là lỗi nghiêm trọng và phổ biến nhất khi cấu hình robots.txt. Nhiều người dùng mới có thể vô tình thêm vào một quy tắc quá rộng, dẫn đến việc chặn cả những nội dung quan trọng. Hậu quả là các trang đó sẽ dần biến mất khỏi kết quả tìm kiếm, gây sụt giảm traffic nghiêm trọng.

Một số lỗi phổ biến cần tránh:

Disallow: /: Đây là quy tắc nguy hiểm nhất, nó yêu cầu tất cả các bot không được truy cập vào bất kỳ trang nào trên toàn bộ website. Chỉ sử dụng quy tắc này khi bạn muốn trang web hoàn toàn không xuất hiện trên công cụ tìm kiếm (ví dụ: website đang trong giai đoạn phát triển).Disallow: /wp-content/uploads/: Quy tắc này sẽ chặn tất cả hình ảnh và các tệp media của bạn. Điều này không chỉ làm mất traffic từ Google Images mà còn ảnh hưởng đến trải nghiệm người dùng khi hình ảnh không hiển thị đúng cách.Disallow: /*.jpg$ sẽ chặn tất cả các file hình ảnh JPG. Hãy chắc chắn rằng bạn hiểu rõ cú pháp và tác động của nó trước khi áp dụng.Luôn kiểm tra kỹ lưỡng các quy tắc của bạn. Một phương pháp tốt là liệt kê các URL quan trọng nhất của website và dùng công cụ kiểm tra để đảm bảo chúng không bị chặn bởi bất kỳ quy tắc nào bạn đã thiết lập. Bạn có thể sử dụng hướng dẫn trong Google Search Console để kiểm tra hiệu quả.

File robots.txt không phải là thứ bạn chỉ cần thiết lập một lần rồi quên đi. Website của bạn là một thực thể sống, liên tục thay đổi và phát triển. Do đó, file robots.txt cũng cần được xem xét và cập nhật định kỳ để luôn phù hợp với cấu trúc hiện tại.

Hãy kiểm tra lại file robots.txt của bạn trong các trường hợp sau:

/du-an/. Bạn cần xem xét liệu có cần thêm quy tắc nào cho mục này hay không.Việc rà soát định kỳ, có thể là hàng quý hoặc sau mỗi lần có thay đổi lớn trên website, sẽ giúp bạn duy trì một file robots.txt khỏe mạnh, luôn hỗ trợ tốt nhất cho chiến lược SEO của mình.

Sau khi đã hiểu rõ cách cấu hình và những lưu ý quan trọng, bước cuối cùng nhưng không kém phần thiết yếu là kiểm tra và duy trì file robots.txt. Việc này đảm bảo rằng các quy tắc của bạn đang hoạt động chính xác và không gây ra bất kỳ lỗi không mong muốn nào. May mắn là có rất nhiều công cụ hữu ích để hỗ trợ bạn trong quá trình này.

Không ai muốn phát hiện ra website của mình biến mất khỏi Google chỉ vì một lỗi cú pháp trong file robots.txt. Do đó, việc sử dụng các công cụ chuyên dụng để kiểm tra là vô cùng cần thiết trước và sau khi bạn thực hiện bất kỳ thay đổi nào.

1. Google Search Console:

Đây là công cụ quan trọng và đáng tin cậy nhất. Google Search Console cung cấp một trình kiểm tra file robots.txt (Robots.txt Tester) cho phép bạn:

Để sử dụng, bạn chỉ cần truy cập vào tài khoản Google Search Console, chọn website của mình và tìm đến công cụ “Robots.txt Tester”.

2. Bing Webmaster Tools:

Tương tự như Google, Bing cũng cung cấp một bộ công cụ cho các webmaster. Trong đó có tính năng kiểm tra robots.txt, giúp bạn đảm bảo website của mình cũng được tối ưu cho công cụ tìm kiếm của Microsoft.

3. Các công cụ kiểm tra trực tuyến khác:

Ngoài các công cụ chính thức từ Google và Bing, có rất nhiều website của bên thứ ba cung cấp tính năng kiểm tra robots.txt miễn phí. Chúng có thể hữu ích để có một cái nhìn nhanh hoặc khi bạn chưa có quyền truy cập vào Search Console. Tuy nhiên, hãy luôn ưu tiên sử dụng công cụ của Google để có kết quả chính xác nhất.

Để tránh mọi rủi ro, bạn nên tuân thủ một quy trình SEO cập nhật an toàn mỗi khi cần chỉnh sửa file robots.txt. Đừng bao giờ chỉnh sửa trực tiếp trên file đang hoạt động mà không có sự chuẩn bị.

Hãy thực hiện theo các bước sau:

Tuân thủ quy trình này sẽ giúp bạn tự tin tối ưu file robots.txt mà không phải lo lắng về những hậu quả tiêu cực.

Để tóm gọn lại những kiến thức quan trọng nhất, dưới đây là danh sách các thực hành tốt nhất (best practices) khi làm việc với file robots.txt cho website WordPress. Hãy xem đây như một checklist để bạn rà soát và đảm bảo file của mình luôn ở trạng thái tối ưu.

/wp-admin/, /wp-includes/ và các tệp cấu hình. Điều này vừa giúp bảo mật, vừa giúp bot tập trung tài nguyên vào những nội dung quan trọng.Sitemap: [URL đến sitemap của bạn] ở cuối file. Đây là cách trực tiếp và hiệu quả nhất để chỉ cho các công cụ tìm kiếm biết tất cả các trang bạn muốn họ thu thập dữ liệu. Để tìm hiểu sâu hơn về kỹ thuật SEO, bạn có thể đọc thêm bài Seo top Google.

Qua bài viết chi tiết này, chúng ta có thể thấy rằng file robots.txt, dù chỉ là một tệp văn bản nhỏ, lại đóng một vai trò vô cùng quan trọng trong hệ sinh thái của một website WordPress. Nó không chỉ là công cụ giúp bạn giao tiếp và định hướng robot tìm kiếm một cách hiệu quả, mà còn là một hàng rào bảo vệ các khu vực quan trọng và góp phần trực tiếp vào việc nâng cao thứ hạng SEO. Việc hiểu rõ, cấu hình chính xác và duy trì file này là một kỹ năng thiết yếu đối với bất kỳ webmaster nào.

Từ việc chặn các thư mục không cần thiết để tiết kiệm ngân sách thu thập dữ liệu, đến việc sử dụng sitemap để tăng tốc độ index, mỗi quy tắc trong file robots.txt đều có tác động đến hiệu suất của website trên các công cụ tìm kiếm. Bỏ qua nó hoặc cấu hình sai lầm có thể dẫn đến những hậu quả không đáng có, làm lãng phí mọi nỗ lực xây dựng nội dung và tối ưu hóa của bạn.

Vì vậy, đừng chần chừ nữa. Hãy bắt đầu kiểm tra và tối ưu file robots.txt của bạn ngay hôm nay để đảm bảo website đang hoạt động ở trạng thái tốt nhất. Hãy áp dụng những kiến thức và thực hành tốt nhất đã được chia sẻ, sử dụng các công cụ seo hỗ trợ để kiểm tra kỹ lưỡng và biến file robots.txt thành một đồng minh đắc lực trong hành trình chinh phục các thứ hạng cao trên Google. Hãy tiếp tục theo dõi các phân tích SEO và cập nhật kiến thức mới để duy trì một file robots.txt tối ưu nhất cho website của bạn trong dài hạn.