Trong kỷ nguyên trí tuệ nhân tạo (AI) phát triển mạnh mẽ như hiện nay, NPU đang ngày càng khẳng định vai trò là một thành phần không thể thiếu trong các thiết bị thông minh. Bạn có bao giờ thắc mắc tại sao chiếc điện thoại của mình có thể nhận diện khuôn mặt tức thì hay dịch ngôn ngữ mà không cần mạng Internet không? Câu trả lời nằm ở một bộ xử lý chuyên dụng có tên là NPU. Tuy nhiên, nhiều người dùng vẫn thường nhầm lẫn giữa NPU với CPU hoặc GPU, và chưa thực sự hiểu rõ chức năng cốt lõi mà nó mang lại. Liệu nó có thực sự quan trọng đến vậy?

Bài viết này sẽ là kim chỉ nam giúp bạn giải đáp mọi thắc mắc. Chúng ta sẽ cùng nhau đi sâu vào việc giải thích chi tiết khái niệm NPU là gì, khám phá cấu tạo và nguyên lý hoạt động đằng sau nó. Hơn thế nữa, bài viết sẽ làm rõ những ứng dụng thực tiễn của NPU trong cuộc sống, so sánh ưu điểm vượt trội của nó so với các bộ xử lý truyền thống, và cuối cùng là phác thảo bức tranh toàn cảnh về xu hướng phát triển của công nghệ này trong tương lai. Hãy cùng Bùi Mạnh Đức bắt đầu hành trình khám phá sức mạnh của bộ xử lý thần kinh ngay bây giờ.

Khái niệm và định nghĩa NPU

Để hiểu rõ sức mạnh của trí tuệ nhân tạo trên các thiết bị hiện đại, trước hết chúng ta cần làm quen với “bộ não” chuyên dụng của nó. Đó chính là NPU. Vậy chính xác thì NPU là gì và nó đóng vai trò như thế nào trong bức tranh công nghệ tổng thể?

NPU là gì?

NPU, viết tắt của Neural Processing Unit, có nghĩa là Bộ xử lý Thần kinh. Đây là một bộ vi xử lý chuyên dụng được thiết kế riêng để tăng tốc các tác vụ liên quan đến trí tuệ nhân tạo và học máy (machine learning). Chức năng chính của nó là thực hiện các phép tính phức tạp của mạng nơ-ron nhân tạo một cách hiệu quả và nhanh chóng. Hãy tưởng tượng NPU như một chuyên gia bậc thầy về ngôn ngữ AI, trong khi các bộ xử lý khác chỉ có thể giao tiếp ở mức cơ bản.

Vậy NPU khác biệt như thế nào so với CPU và GPU? Hãy phân biệt rõ ràng ba khái niệm này:

- CPU (Central Processing Unit – Bộ xử lý trung tâm): Được ví như “bộ não” đa năng của một thiết bị. CPU được thiết kế để xử lý tuần tự một loạt các tác vụ đa dạng, từ việc chạy hệ điều hành, mở ứng dụng, đến lướt web. Nó linh hoạt nhưng lại không phải là lựa chọn tối ưu cho các phép toán lặp đi lặp lại của AI.

- GPU (Graphics Processing Unit – Bộ xử lý đồ họa): Ban đầu được tạo ra để xử lý đồ họa phức tạp trong game và video. GPU có khả năng xử lý song song hàng nghìn phép tính cùng lúc, do đó nó cũng khá hiệu quả cho việc huấn luyện AI. Tuy nhiên, nó tiêu thụ nhiều năng lượng hơn và không được tối ưu hoàn toàn cho các thuật toán suy luận AI như NPU. Tìm hiểu chi tiết về GPU là gì.

- NPU (Neural Processing Unit – Bộ xử lý thần kinh): Là một “chuyên gia” chỉ tập trung vào một lĩnh vực duy nhất: xử lý mạng n-ơron. Kiến trúc của NPU được tinh chỉnh để thực hiện các phép tính ma trận và vector – nền tảng của AI – với tốc độ cực nhanh và hiệu suất năng lượng vượt trội. Nó giống như một vận động viên chuyên nghiệp, được rèn luyện chỉ để chiến thắng trong một bộ môn cụ thể.

Vai trò của NPU trong công nghệ hiện đại

Sự ra đời của NPU đã tạo ra một cuộc cách mạng trong việc triển khai AI, đặc biệt là trên các thiết bị cá nhân. Vai trò của nó không chỉ dừng lại ở việc tăng tốc độ, mà còn mang lại nhiều lợi ích chiến lược. Một trong những vai trò quan trọng nhất là tối ưu hóa việc xử lý các mạng nơ-ron và thuật toán AI. Thay vì đẩy gánh nặng tính toán cho CPU hoặc GPU, NPU đảm nhận công việc này, giải phóng tài nguyên hệ thống cho các tác vụ khác. Điều này giúp thiết bị hoạt động mượt mà hơn, ngay cả khi đang chạy các ứng dụng AI nặng. Để hiểu rõ hơn về mạng nơ-ron nhân tạo – nền tảng của AI mà NPU chuyên xử lý.

Hơn nữa, NPU đóng vai trò then chốt trong việc tăng hiệu suất và tiết kiệm năng lượng. Các thuật toán AI đòi hỏi một khối lượng tính toán khổng lồ. Nếu sử dụng CPU hoặc GPU, chúng sẽ tiêu tốn rất nhiều điện năng, gây nóng máy và làm giảm tuổi thọ pin nhanh chóng. NPU giải quyết bài toán này bằng cách thực hiện cùng một khối lượng công việc nhưng với mức tiêu thụ năng lượng thấp hơn nhiều lần. Nhờ vậy, các tính năng AI thông minh như nhận diện giọng nói, xử lý hình ảnh theo thời gian thực có thể hoạt động liên tục trên điện thoại của bạn mà không biến nó thành một “cục than nóng”. Đây chính là yếu tố cho phép AI thực sự “sống” trên thiết bị của người dùng (On-device AI) thay vì phụ thuộc hoàn toàn vào kết nối đám mây. Khám phá thêm về Điện toán đám mây là gì trong liên quan đến AI và NPU.

Cấu tạo và nguyên lý hoạt động của NPU

Để tạo ra hiệu suất đột phá cho các tác vụ AI, NPU sở hữu một kiến trúc phần cứng và nguyên lý hoạt động hoàn toàn khác biệt so với CPU. Hiểu được cấu trúc bên trong của nó sẽ giúp chúng ta thấy rõ tại sao nó lại hiệu quả đến vậy. Hãy cùng “mổ xẻ” để khám phá bí mật đằng sau bộ xử lý thần kinh này.

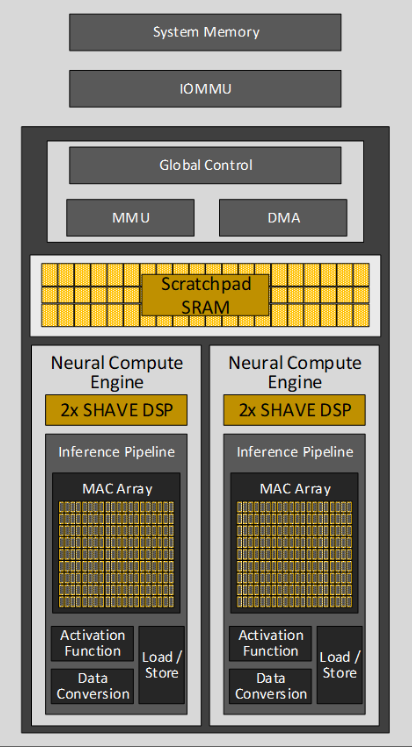

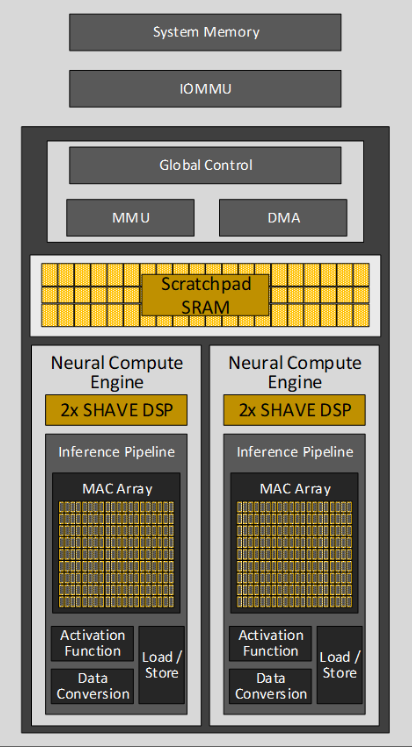

Cấu tạo cơ bản của NPU

Cấu trúc của một NPU được thiết kế tối giản nhưng tập trung cao độ vào mục tiêu duy nhất: xử lý thuật toán AI. Nó không cần những thành phần phức tạp để xử lý các tác vụ đa dạng như CPU. Thay vào đó, nó bao gồm các thành phần chính được chuyên biệt hóa.

Thành phần cốt lõi và quan trọng nhất của NPU là bộ xử lý ma trận (Matrix Multiply Unit). Đây là nơi diễn ra hàng nghìn, thậm chí hàng triệu phép nhân và cộng song song, vốn là nền tảng của các mô hình học sâu. Bên cạnh đó, NPU còn có các khối bộ nhớ truy cập nhanh (thường là SRAM) nằm ngay bên trong chip. Bộ nhớ này dùng để lưu trữ các trọng số (weights) và dữ liệu đầu vào (inputs) của mạng nơ-ron, giúp giảm độ trễ khi truy xuất dữ liệu so với việc lấy từ RAM chính của hệ thống. Cuối cùng, một đơn vị điều khiển (Control Unit) sẽ quản lý luồng dữ liệu, điều phối hoạt động giữa bộ xử lý ma trận và bộ nhớ để đảm bảo chu trình tính toán diễn ra một cách nhịp nhàng và hiệu quả nhất. Toàn bộ kiến trúc này được xây dựng để phục vụ cho các phép tính đặc thù của AI, loại bỏ mọi thành phần thừa thãi không cần thiết.

Nguyên lý hoạt động của NPU

Nguyên lý hoạt động của NPU dựa trên hai yếu tố chính: xử lý song song hàng loạt và tối ưu hóa cho các phép toán của mạng nơ-ron sâu (Deep learning là gì). Thay vì xử lý từng lệnh một cách tuần tự như CPU, NPU được thiết kế để thực hiện một lượng lớn các phép tính giống hệt nhau cùng một lúc. Hãy hình dung một dây chuyền lắp ráp khổng lồ, nơi mỗi công nhân (một đơn vị tính toán nhỏ trong NPU) chỉ làm một việc đơn giản là nhân hai con số rồi cộng chúng lại. Với hàng nghìn công nhân làm việc đồng thời, dây chuyền này có thể sản xuất ra một khối lượng sản phẩm khổng lồ trong thời gian ngắn. Đây chính là cách NPU xử lý các lớp (layers) trong một mạng nơ-ron.

Cụ thể hơn, hoạt động của NPU được tối ưu hóa cho mạng nơ-ron sâu. Khi một mô hình AI cần xử lý dữ liệu, ví dụ như nhận dạng một hình ảnh, dữ liệu hình ảnh đó sẽ được chuyển đổi thành các ma trận số. NPU sẽ nhận ma trận này và thực hiện các phép nhân ma trận với các trọng số đã được huấn luyện từ trước của mô hình. Quá trình này diễn ra qua nhiều lớp của mạng nơ-ron, với mỗi lớp tinh chỉnh và trích xuất các đặc điểm ngày càng phức tạp hơn, từ các cạnh và góc đơn giản đến các hình dạng phức tạp như mắt, mũi, và cuối cùng là cả khuôn mặt. Nhờ kiến trúc chuyên dụng, NPU hoàn thành chuỗi tính toán này với tốc độ đáng kinh ngạc và hiệu suất năng lượng vượt trội, điều mà CPU và GPU không thể sánh bằng.

Ứng dụng của NPU trong trí tuệ nhân tạo và học máy

Sức mạnh của NPU không chỉ nằm trên lý thuyết. Nó đã và đang được tích hợp sâu rộng vào cuộc sống hàng ngày của chúng ta, từ chiếc điện thoại thông minh trong túi bạn cho đến các trung tâm dữ liệu khổng lồ vận hành thế giới số. Hãy cùng khám phá những ứng dụng thực tiễn ấn tượng nhất của bộ xử lý thần kinh.

Ứng dụng trong thiết bị di động và IoT

Đây là lĩnh vực mà người dùng cuối cảm nhận rõ rệt nhất sự hiện diện của NPU. Trên các thiết bị di động, NPU là động lực đằng sau hàng loạt tính năng thông minh. Ví dụ điển hình là AI Camera. Khi bạn chụp ảnh ở chế độ chân dung, NPU sẽ làm việc để phân tích và tách biệt chủ thể khỏi hậu cảnh, sau đó áp dụng hiệu ứng xóa phông một cách tự nhiên và chính xác chỉ trong tích tắc. Nó cũng giúp nhận diện cảnh vật (bãi biển, thành phố, món ăn) để tự động tối ưu màu sắc và độ sáng cho bức ảnh đẹp nhất.

Ngoài ra, khả năng nhận diện giọng nói cũng được nâng cấp vượt bậc nhờ NPU. Các trợ lý ảo như Siri, Google Assistant có thể hiểu và phản hồi lệnh của bạn ngay lập tức, thậm chí khi không có kết nối Internet. Điều này là do NPU xử lý âm thanh trực tiếp trên thiết bị, giúp tăng tốc độ và bảo vệ quyền riêng tư. Không chỉ smartphone, các thiết bị IoT (Internet of Things) như chuông cửa thông minh, camera an ninh cũng tích hợp NPU để nhận diện người quen và người lạ, gửi cảnh báo chính xác hơn, hay lọc ra các chuyển động không đáng kể do vật nuôi hoặc lá cây gây ra. Tất cả những điều này làm cho cuộc sống của chúng ta trở nên tiện lợi và an toàn hơn. Tìm hiểu sâu hơn về Machine learning là gì để thấy ứng dụng của nó trên thiết bị di động và IoT.

Ứng dụng trong trung tâm dữ liệu và máy chủ AI

Nếu như ở thiết bị di động, NPU tập trung vào “suy luận” (inference) – tức là áp dụng mô hình AI đã có – thì ở các trung tâm dữ liệu, vai trò của nó còn mở rộng sang cả “huấn luyện” (training). Các công ty công nghệ lớn như Google, Meta, Amazon sử dụng những bộ xử lý AI chuyên dụng (tương tự NPU nhưng ở quy mô lớn hơn nhiều, như TPU của Google) để “dạy” cho các mô hình AI của họ. Quá trình này đòi hỏi xử lý một khối lượng dữ liệu khổng lồ (Big Data) và hàng tỷ tỷ phép tính. Việc sử dụng các chip AI chuyên dụng giúp tăng tốc quá trình huấn luyện từ vài tháng xuống chỉ còn vài ngày hoặc vài giờ.

Bên cạnh đó, NPU cũng đóng vai trò quan trọng trong việc cung cấp các dịch vụ AI trên nền tảng đám mây. Khi bạn sử dụng một công cụ dịch thuật trực tuyến hay một dịch vụ chỉnh sửa ảnh dựa trên AI, yêu cầu của bạn sẽ được gửi đến một máy chủ. Tại đây, các NPU hoặc bộ tăng tốc AI sẽ xử lý yêu cầu đó và trả kết quả về cho bạn. Việc trang bị NPU cho các máy chủ giúp các công ty cung cấp dịch vụ AI cho hàng triệu người dùng cùng lúc một cách nhanh chóng và ổn định. Chúng giúp giảm chi phí vận hành, tiết kiệm điện năng và làm cho các dịch vụ AI tiên tiến trở nên dễ tiếp cận hơn bao giờ hết. Tham khảo thêm về Data science là gì liên quan đến việc phân tích và xử lý dữ liệu trong AI.

Ưu điểm khi sử dụng NPU so với các bộ xử lý truyền thống

Sự trỗi dậy của NPU không phải là ngẫu nhiên. Nó mang lại những lợi ích rõ rệt và mang tính cách mạng so với việc chỉ dựa vào CPU và GPU cho các tác vụ AI. Hai ưu điểm lớn nhất và thuyết phục nhất chính là hiệu suất xử lý vượt trội và khả năng tiết kiệm năng lượng đáng kinh ngạc. Đây là những yếu tố then chốt quyết định tính khả thi của việc triển khai AI trên diện rộng.

Hiệu suất xử lý nâng cao

Ưu điểm nổi bật đầu tiên của NPU chính là tốc độ. Như đã đề cập, kiến trúc của NPU được “đo ni đóng giày” cho các phép tính ma trận – trái tim của mạng nơ-ron. Trong khi CPU phải xử lý từng phép tính một cách tuần tự, NPU có thể thực hiện hàng ngàn phép tính song song trong cùng một chu kỳ xung nhịp. Điều này tạo ra một sự khác biệt khổng lồ về hiệu suất. Đối với các tác vụ suy luận AI, một NPU có thể nhanh hơn hàng chục, thậm chí hàng trăm lần so với một CPU cao cấp.

Sự tăng tốc này không chỉ là những con số trên giấy. Nó được thể hiện qua trải nghiệm người dùng thực tế. Ví dụ, việc mở khóa bằng khuôn mặt diễn ra gần như tức thì, các bộ lọc AR (thực tế tăng cường) trên mạng xã hội hoạt động mượt mà không giật lag, hay việc phân loại hàng nghìn bức ảnh trong thư viện của bạn chỉ mất vài giây. Việc tăng tốc độ xử lý mạng neural không chỉ làm cho các tính năng hiện có tốt hơn mà còn mở đường cho các ứng dụng AI phức tạp hơn trong tương lai, những ứng dụng đòi hỏi khả năng phản hồi theo thời gian thực mà CPU hay GPU đơn thuần không thể đáp ứng nổi.

Tiết kiệm năng lượng và chi phí

Hiệu suất cao thường đi đôi với tiêu thụ năng lượng lớn, nhưng NPU lại là một ngoại lệ. Đây chính là ưu điểm mang tính thay đổi cuộc chơi của nó. Vì được thiết kế chuyên dụng, NPU loại bỏ tất cả các mạch logic không cần thiết cho việc tính toán AI. Nó chỉ tập trung tài nguyên vào đúng công việc cần làm, giúp đạt được hiệu suất trên mỗi watt (performance-per-watt) cao hơn rất nhiều so với CPU và GPU. Nói một cách đơn giản, NPU hoàn thành công việc nhanh hơn và tiêu thụ ít điện năng hơn đáng kể.

Lợi ích này có ý nghĩa to lớn ở hai quy mô. Đối với thiết bị di động và IoT, việc tiêu thụ điện năng thấp giúp kéo dài tuổi thọ pin một cách ấn tượng. Bạn có thể sử dụng các tính năng AI cả ngày mà không lo hết pin giữa chừng. Đồng thời, vì tiêu thụ ít năng lượng hơn, NPU tỏa ra ít nhiệt hơn, giúp thiết bị hoạt động mát mẻ và bền bỉ hơn. Ở quy mô lớn của các trung tâm dữ liệu, việc tiết kiệm năng lượng đồng nghĩa với việc giảm hàng triệu đô la chi phí tiền điện và chi phí cho các hệ thống làm mát phức tạp. Điều này giúp giảm chi phí vận hành các dịch vụ AI, từ đó thúc đẩy việc áp dụng AI rộng rãi hơn trong mọi ngành công nghiệp.

Tương lai phát triển và xu hướng công nghệ NPU

Công nghệ NPU vẫn còn rất non trẻ nhưng đang phát triển với tốc độ vũ bão. Khi trí tuệ nhân tạo ngày càng len lỏi sâu hơn vào mọi khía cạnh của cuộc sống và công việc, nhu cầu về các bộ xử lý chuyên dụng càng trở nên cấp thiết. Tương lai của NPU hứa hẹn sẽ còn nhiều đột phá và đổi mới hơn nữa.

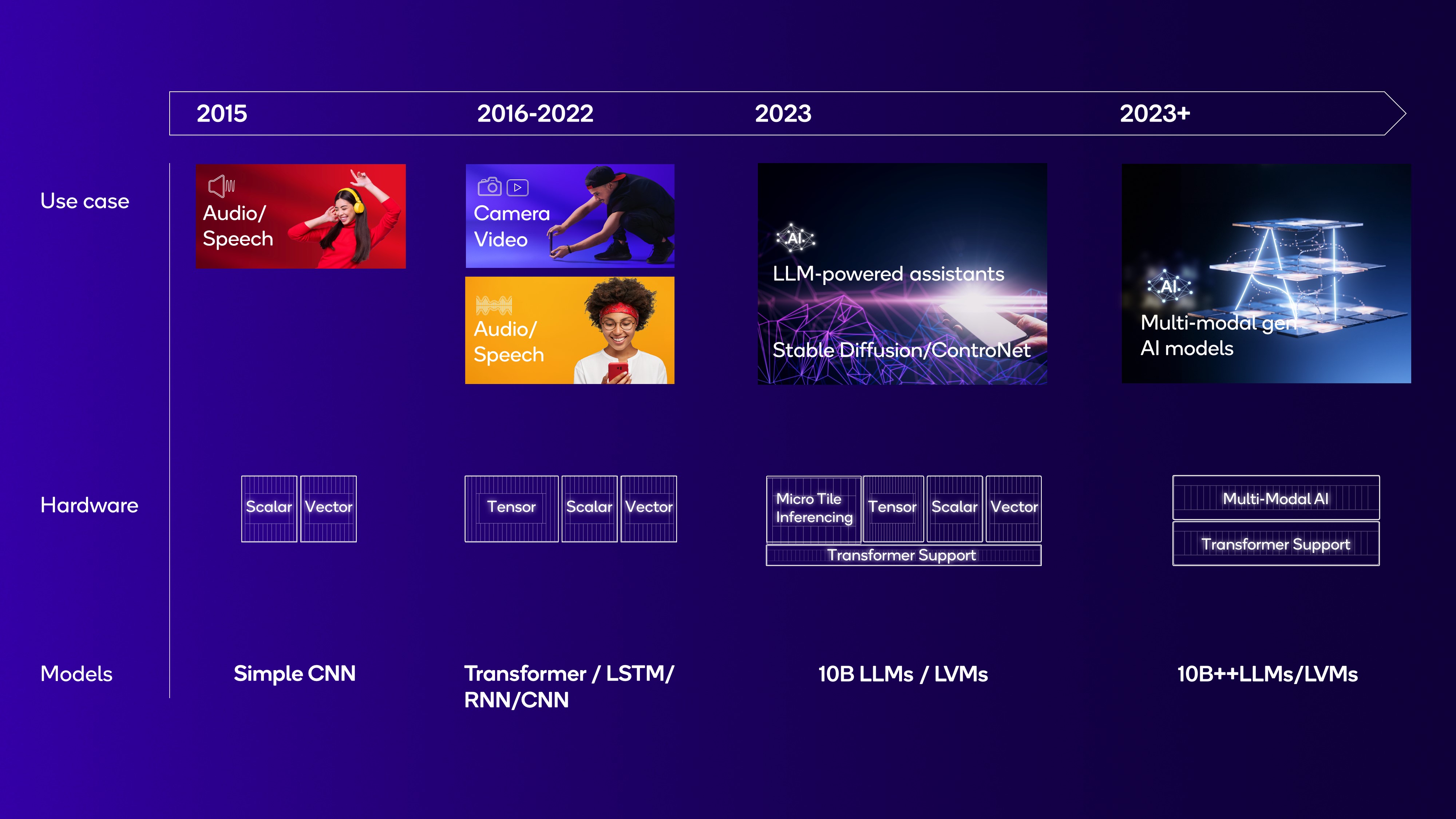

Sự bùng nổ của AI và nhu cầu NPU

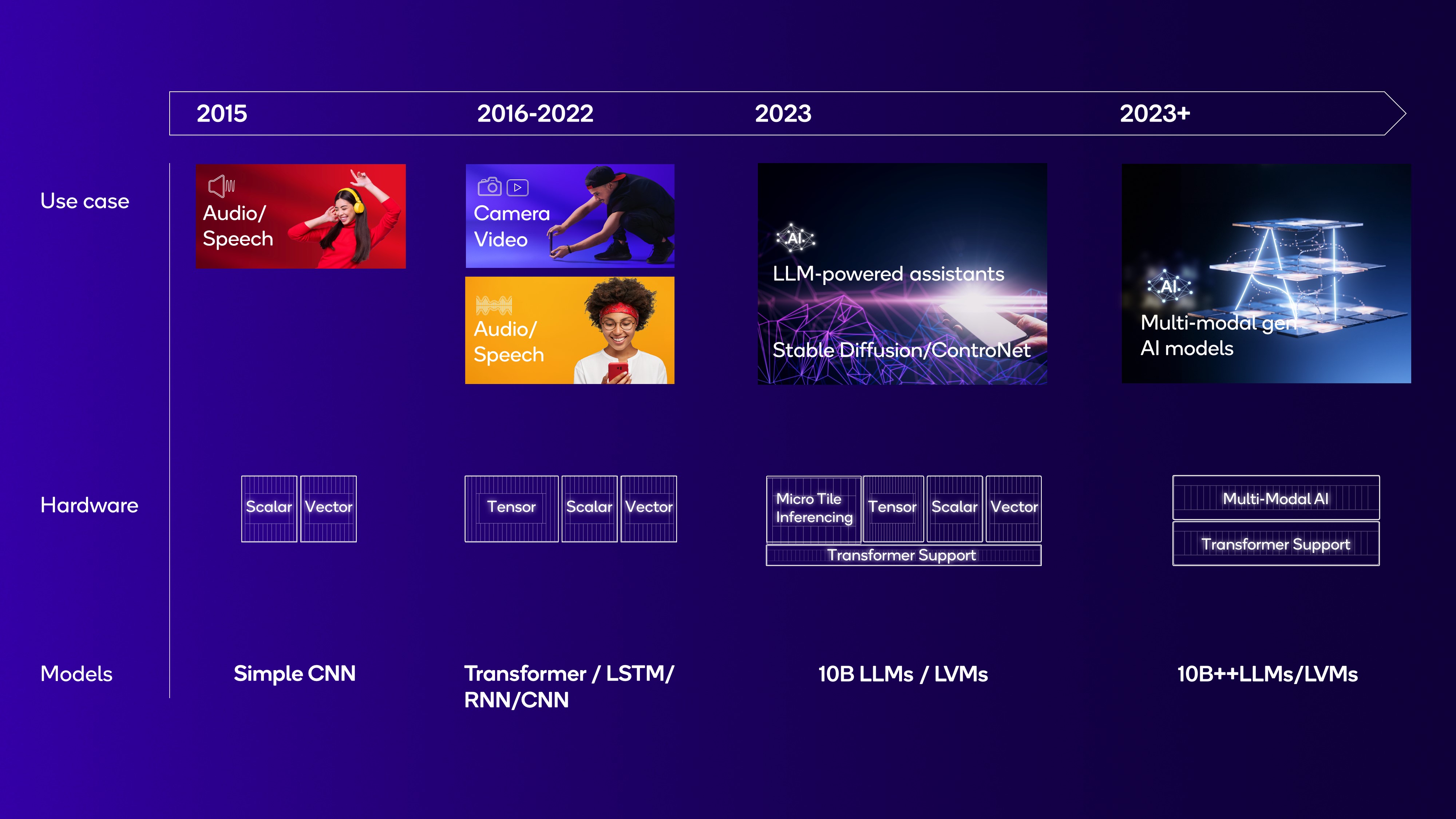

Chúng ta đang chứng kiến sự bùng nổ của AI trên mọi mặt trận, từ AI tạo sinh (Generative AI) có thể viết văn, vẽ tranh cho đến các hệ thống tự hành phức tạp. Xu hướng này trực tiếp thúc đẩy nhu cầu về những con chip NPU mạnh mẽ và hiệu quả hơn. Trong tương lai gần, NPU sẽ không còn là một tính năng cao cấp trên các dòng flagship mà sẽ trở thành một thành phần tiêu chuẩn trên hầu hết các thiết bị điện tử, từ điện thoại thông minh, máy tính xách tay, xe hơi, cho đến cả thiết bị gia dụng.

Sự phổ biến này sẽ mở ra một làn sóng ứng dụng mới. Hãy tưởng tượng một chiếc máy tính có thể dự đoán nhu cầu của bạn và tự động mở các ứng dụng cần thiết, một chiếc xe ô tô có thể giao tiếp và phối hợp với các phương tiện khác để tránh tắc đường, hay một hệ thống y tế có thể chẩn đoán bệnh sớm ngay tại nhà thông qua các thiết bị đeo thông minh. Tất cả những điều đó đều cần đến sức mạnh xử lý AI tại chỗ (on-device) mà NPU cung cấp. Do đó, cuộc đua phát triển chip NPU giữa các ông lớn công nghệ như Apple, Google, Qualcomm, và Samsung sẽ ngày càng gay gắt, mang lại lợi ích trực tiếp cho người tiêu dùng.

Đổi mới công nghệ và tích hợp đa chức năng

Công nghệ NPU trong tương lai sẽ không chỉ nhanh hơn mà còn thông minh hơn. Một trong những xu hướng quan trọng là tích hợp NPU với các công nghệ mới như Edge Computing (Điện toán biên). Thay vì gửi mọi dữ liệu lên đám mây, các thiết bị sẽ tự xử lý thông tin tại chỗ nhờ NPU, giúp giảm độ trễ, tăng cường bảo mật và hoạt động ổn định ngay cả khi không có mạng. Điều này đặc biệt quan trọng cho các ứng dụng như xe tự lái hay robot công nghiệp, nơi mỗi mili giây đều quý giá.

Bên cạnh đó, các nhà sản xuất đang hướng tới việc phát triển những con chip đa lõi, kết hợp nhiều NPU trên cùng một đế silicon để xử lý các mô hình AI ngày càng phức tạp. Một xu hướng đột phá khác là phát triển các NPU có khả năng tự học và tự tối ưu hóa. Những con chip này có thể phân tích cách chúng đang được sử dụng và tự điều chỉnh kiến trúc bên trong để thực thi các tác vụ hiệu quả hơn theo thời gian. Cuối cùng, NPU sẽ được tích hợp chặt chẽ hơn với CPU và GPU để tạo thành một hệ thống xử lý không đồng nhất (heterogeneous computing), nơi mỗi tác vụ sẽ được tự động gán cho bộ xử lý phù hợp nhất, mang lại hiệu suất tổng thể tối ưu cho toàn bộ hệ thống.

Common Issues/Troubleshooting

Mặc dù NPU mang lại nhiều lợi ích vượt trội, công nghệ này vẫn còn ở giai đoạn phát triển và đối mặt với một số thách thức nhất định. Việc hiểu rõ những vấn đề này giúp các nhà phát triển và người dùng có cái nhìn thực tế hơn về khả năng và giới hạn của NPU ở thời điểm hiện tại. Hai trong số các vấn đề phổ biến nhất là khả năng tương thích phần mềm và giới hạn xử lý.

Vấn đề tương thích phần mềm với NPU

Một trong những thách thức lớn nhất hiện nay là sự phân mảnh của hệ sinh thái NPU. Không giống như CPU có một tập lệnh khá chuẩn (như x86 hoặc ARM), mỗi nhà sản xuất NPU (Qualcomm, Apple, MediaTek, Samsung) lại có một kiến trúc phần cứng và bộ công cụ phát triển phần mềm (SDK) riêng biệt. Điều này tạo ra một rào cản lớn cho các nhà phát triển ứng dụng AI. Họ không thể chỉ viết một đoạn mã và mong nó chạy tối ưu trên tất cả các thiết bị.

Để khai thác tối đa sức mạnh của một NPU cụ thể, lập trình viên phải sử dụng các framework được hỗ trợ như TensorFlow Lite, Core ML (của Apple), hay NNAPI (của Android) và đôi khi phải tối ưu hóa mô hình AI của mình cho từng loại chip. Quá trình này đòi hỏi kiến thức chuyên sâu và tốn nhiều thời gian, công sức. Nếu phần mềm không được tối ưu hóa đúng cách, ứng dụng AI có thể sẽ không tận dụng được NPU mà quay về chạy trên CPU hoặc GPU, dẫn đến hiệu suất kém và tiêu tốn nhiều năng lượng hơn. Đây là bài toán mà ngành công nghiệp đang nỗ lực giải quyết thông qua việc chuẩn hóa các API và framework.

Giới hạn khả năng xử lý đối với các mô hình phức tạp

NPU là một chuyên gia, và như mọi chuyên gia, nó có những giới hạn. Nó được thiết kế để tăng tốc các loại phép toán phổ biến trong các mạng nơ-ron thông thường. Tuy nhiên, lĩnh vực AI đang phát triển không ngừng với sự ra đời của các kiến trúc mô hình mới, phức tạp và đôi khi rất khác biệt so với trước đây. Một NPU được thiết kế hôm nay có thể gặp khó khăn trong việc xử lý hiệu quả một loại mạng nơ-ron hoàn toàn mới được phát minh vào ngày mai.

Ví dụ, một NPU có thể xử lý cực nhanh các mô hình nhận dạng hình ảnh (CNN) nhưng lại không tối ưu cho các mô hình ngôn ngữ lớn (GPT 4) hoặc các mạng nơ-ron đồ thị (GNN). Hơn nữa, khi một mô hình AI trở nên quá lớn hoặc yêu cầu xử lý đa nhiệm quá cao (ví dụ: vừa nhận dạng giọng nói, vừa phân tích hình ảnh, vừa dịch thuật cùng lúc), NPU trên các thiết bị di động có thể đạt đến giới hạn về bộ nhớ và khả năng tính toán. Trong những trường hợp này, một phần hoặc toàn bộ gánh nặng xử lý sẽ phải chuyển sang GPU hoặc thậm chí là các máy chủ trên đám mây, làm mất đi lợi thế về tốc độ và hiệu suất năng lượng của NPU.

Best Practices

Để khai thác tối đa tiềm năng của NPU và tránh các vấn đề phổ biến, cả nhà phát triển lẫn người dùng cần tuân thủ một số nguyên tắc và phương pháp tốt nhất. Việc áp dụng những thực hành này giúp đảm bảo các ứng dụng AI chạy mượt mà, hiệu quả và tận dụng được toàn bộ sức mạnh của phần cứng chuyên dụng.

- Sử dụng SDK và framework hỗ trợ NPU: Đối với các nhà phát triển, đây là bước quan trọng nhất. Thay vì cố gắng viết mã cấp thấp, hãy sử dụng các bộ công cụ phát triển phần mềm (SDK) và các framework cấp cao như TensorFlow Lite, PyTorch Mobile, Apple Core ML, hoặc Qualcomm SNPE. Các công cụ này được thiết kế để tự động tối ưu hóa và biên dịch mô hình AI của bạn sang định dạng có thể chạy hiệu quả trên NPU của thiết bị đích.

- Ưu tiên thiết kế mô hình AI phù hợp với kiến trúc NPU: Không phải tất cả các mô hình AI đều được tạo ra như nhau. Khi thiết kế một mô hình để chạy trên thiết bị di động, hãy ưu tiên các kiến trúc đã được chứng minh là hoạt động tốt trên NPU, ví dụ như MobileNet hay EfficientNet. Sử dụng các kỹ thuật như lượng tử hóa (quantization) để giảm kích thước mô hình và độ phức tạp tính toán cũng là một phương pháp cực kỳ hiệu quả.

- Tránh tải quá nhiều tác vụ không liên quan lên NPU: Hãy nhớ rằng NPU là một bộ xử lý chuyên dụng. Đừng cố gắng sử dụng nó cho các công việc tính toán thông thường không phải là AI. Việc phân chia tác vụ một cách thông minh – để CPU lo việc điều khiển chung, GPU lo đồ họa và NPU tập trung hoàn toàn vào suy luận AI – sẽ mang lại hiệu suất tổng thể tốt nhất cho hệ thống.

- Đảm bảo cập nhật firmware và driver mới nhất: Đối với người dùng cuối, một trong những cách đơn giản nhất để đảm bảo hiệu suất NPU tốt nhất là luôn cập nhật hệ điều hành và các ứng dụng. Các nhà sản xuất thiết bị và nhà phát triển ứng dụng thường xuyên tung ra các bản cập nhật để cải thiện driver cho NPU, tối ưu hóa hiệu suất và sửa lỗi tương thích. Việc cập nhật thường xuyên đảm bảo bạn luôn được hưởng lợi từ những cải tiến mới nhất.

Conclusion

Qua những phân tích chi tiết, chúng ta có thể thấy rõ ràng rằng NPU không chỉ là một thuật ngữ công nghệ thời thượng. Nó là một bộ vi xử lý chuyên dụng, đóng vai trò then chốt trong việc hiện thực hóa sức mạnh của trí tuệ nhân tạo ngay trên các thiết bị chúng ta sử dụng hàng ngày. Những điểm chính cần nhớ là: NPU được thiết kế đặc biệt để tăng tốc các thuật toán AI, mang lại hiệu suất xử lý vượt trội so với CPU và GPU trong khi tiêu thụ ít năng lượng hơn đáng kể. Từ việc chụp ảnh thông minh, nhận diện giọng nói tức thì cho đến việc vận hành các trung tâm dữ liệu khổng lồ, NPU chính là động lực thầm lặng đằng sau cuộc cách mạng AI.

Với kiến thức này, bạn đã có thể tự tin hơn khi lựa chọn các sản phẩm công nghệ. Lần tới khi mua một chiếc điện thoại hay máy tính mới, hãy thử khám phá ngay các thiết bị được tích hợp NPU hoặc “AI Engine” để trực tiếp trải nghiệm sức mạnh của AI hiện đại. Bạn sẽ nhận thấy sự khác biệt rõ rệt trong tốc độ và sự mượt mà của các tính năng thông minh. Công nghệ NPU đang phát triển không ngừng và chắc chắn sẽ định hình tương lai của thế giới số. Vì vậy, hãy tiếp tục theo dõi các xu hướng công nghệ mới và chuẩn bị sẵn sàng để ứng dụng sức mạnh của NPU vào công việc và cuộc sống, mở ra những tiềm năng không giới hạn trong các giải pháp AI tương lai.